LLaMA-Factory 是一个开源的低代码大模型训练与微调框架,旨在简化大规模语言模型(LLM)的微调、评估和部署流程。以下是其核心特性和详细介绍:

1. 核心功能与定位

- 目标用户:面向研究人员和开发者,尤其适合缺乏深度学习背景但需要快速微调模型的人群 [5] [13]。

- 核心优势:

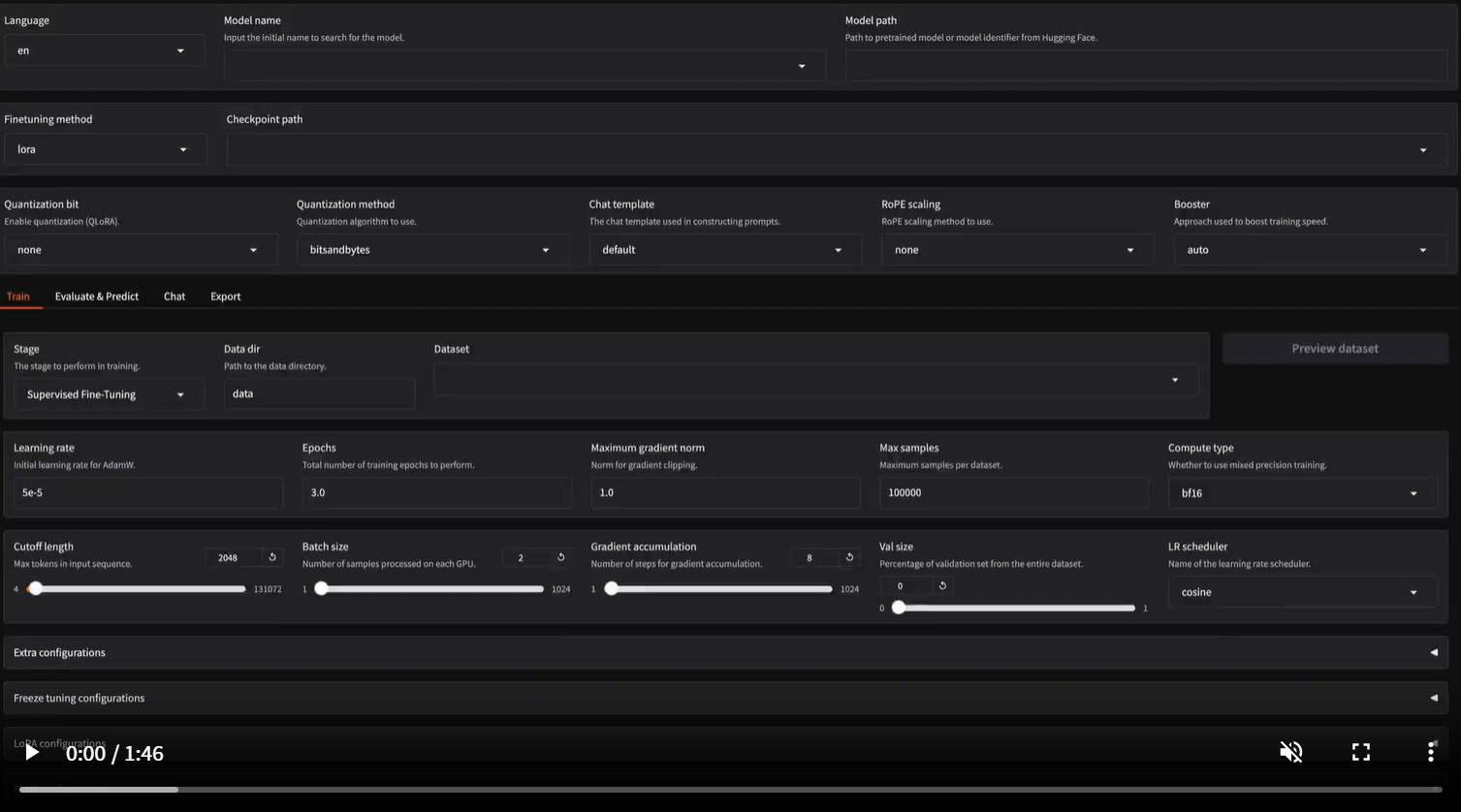

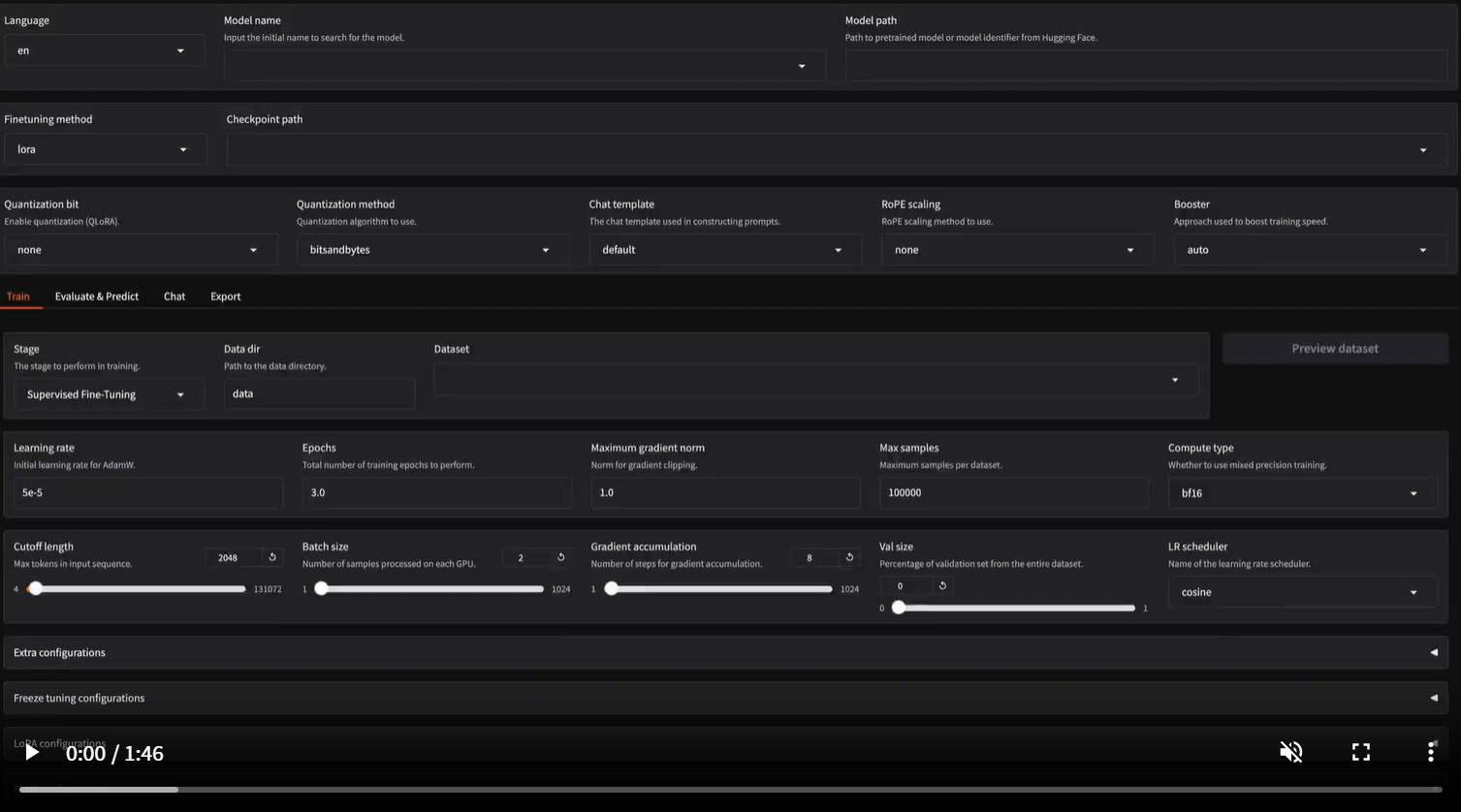

- 无需编码:通过Web UI或配置文件即可完成微调 [2]。

- 高效训练:支持LoRA等高效微调技术,相比传统方法(如P-Tuning)提速3.7倍,且效果更优(如更高的Rouge分数)[17] [23]。

- 资源优化:支持4比特量化技术,降低显存需求 [20]。

2. 支持的模型与数据集

- 模型覆盖:适配超过100种主流开源模型,包括:

- 基础架构:LLaMA、LLaVA、Mistral、Mixtral-MoE、Qwen、Yi、Gemma等 [2] [11]。

- 领域模型:如医疗领域的Sunsimiao(基于Baichuan-7B)、CareGPT(基于LLaMA2-7B)[9] [12]。

- 数据集支持:涵盖50+数据集,包括通用文本和垂直领域(如医疗、广告文案生成)[21]。

3. 技术架构

LLaMA-Factory 由三大模块组成 [3] [21]:

- Model Loader:统一加载不同架构的预训练模型。

- Data Worker:处理多任务数据,支持自定义数据集和模板。

- Trainer:集成高效微调方法(如LoRA、QLoRA)、混合精度训练和分布式训练。

4. 典型应用场景

- 垂直领域微调:例如医疗问答、广告文案生成 [17]。

- 快速部署:支持导出微调后的模型至Hugging Face或本地服务 [18]。

- 教育与研究:提供零代码界面,适合教学和实验 [15]。

5. 性能对比(示例)

| 微调方法 |

训练速度(对比基准) |

Rouge分数提升 |

显存占用 |

| LLaMA-Factory LoRA |

3.7倍加速 [17] |

+15% [23] |

降低50% [20] |

| 传统P-Tuning |

基准1倍 |

- |

高 |

6. 生态与扩展

- 集成平台:与Amazon SageMaker结合提供一站式无代码平台 [16]。

- 社区项目:如Sunsimiao(医疗模型)、MachineMindset(教育模型)等 [12]。

7. 快速开始

- 安装:通过GitHub仓库克隆项目,依赖Python 3.8+和PyTorch [1]。

- 教程:官方提供从环境搭建到模型训练的保姆级指南 [14]。

LLaMA-Factory 通过模块化设计和高效技术栈,显著降低了大模型微调的门槛,是当前开源社区中领先的低代码LLM训练解决方案之一。

https://github.com/hiyouga/LLaMA-Factory

全部评论: 0 条

全部评论: 0 条